Возник такой вопрос в одном из обсуждений в фейсбуке. Я считаю, что глупо тиранить кандидата вопросами про то, что такое релевантность или формула BM-25. Все это можно при необходимости нагуглить. В рутинной работе это точно не поможет. Зато поможет умение нестандартно и в то же время логично мыслить. Так что я бы больше тратил время на опрос по базовым знаниям в практической плоскости.

В итоге составился вот такой списочек, ответы на вопросы в котором могут быть разными и в то же время правильными. Но зато будет видно, почему оптимизатор принял именно такое решение.

В поисковой оптимизации важен не правильный ответ — корректных вариантов может быть несколько, а показать ход рассуждений. Не надо бояться невежества, информации очень много по теме, все не освоить никому. Но если вы умеете думать в направлении как решать задачу, откуда брать необходимые данные для внедрения и расчетов, то все у вас получится. Оставшиеся лакуны заполнит практика. А теперь перейдем к тому, каких ответов я бы ждал на свои вопросы.

Создайте конкурс на workspace.ru – получите предложения от участников CMS Magazine по цене и срокам. Это бесплатно и займет 5 минут. В каталоге 15 617 диджитал-агентств, готовых вам помочь – выберите и сэкономьте до 30%.

Создать конкурс →

На ядро

-

Здесь сначала надо разобраться, что такое информационный. Информационным изначально считали запросы, ответом на которые будет информационный материал, отвечающий на вопрос что, как, где и т.д., т.е. топ будет представлен в основном справочниками, отзовиками, инфосайтами, новостниками. Ярким примером информационного запроса будет название почти любой болезни. Здесь следует понимать, что наполнение топа и, следовательно, его информационность не угадывается поиском, а складывается из реакций пользователей. И если найдется достаточное количество тех, кто ищет по информационному запросу магазин, то он появится в выдаче по этому запросу.

Важное свойство такого информационного запроса — геонезависимость. Если тип запроса меняется, то в выдаче по нему появляются коммерческие сайты, а сам запрос может стать геозависимым: т.е. набор коммерческих сайтов будет отличаться в зависимости от региона. Пример такого запроса: урология — по этому запросу хватает в выдаче сайтов клиник.

Второе, что нужно пояснить, что и информационность, и геозависимость — небинарные понятия. Точнее, геозависимость — бинарна, но в локальную выдачу могут подмешиваться сайты из других регионов или вообще внерегиональные. Некоторые меряют этот показатель в числе сайтов каждого типа в топ10, но это тоже не совсем верно, хотя и дает представление о том, сколько вакансий на сегодня поиск отводит под тот или иной тип сайтов. Но здесь для оценки лучше использовать не числа, а категории типа «почти все», «примерно половина», «одну-две», «почти не встречается».

Дальше ответ становится очевидным. Берем запрос, смотрим топ, проверяем на информационность и геозависимость, берем второй запрос, проверяем. Ответ готов.

Отдельно стоит описать случай засилья агрегаторов в топе. Некоторые специалисты сегодня называют информационными запросы с большим числом агрегаторов и товарных справочников в топе. Хотя, конечно, интент здесь продолжает оставаться больше коммерческим (цель: покупка, заказ) нежели информационным. Но всем ясно, что пробиться в топ по такому запросу корпоративному сайту будет почти невозможно. Так что эти запросы есть смысл отделять от тех коммерческих запросов, где представленность корпоративными сайтами значительно выше.

-

Надо смотреть на тип запроса. Если сайт коммерческий и интент запроса тоже коммерческого плана, то такой запрос можно оставить. Пример был выше — запрос «урология» (особенно в регионах). Если сайт коммерческий, а интент запроса информационный — нафиг из ядра. Пример: «гостевой дом».

-

99% запросов в ядре — названия товаров. Что будете делать?

Такие запросы не несут обычно пользы в том плане, что вы все равно внедрите их по умолчанию на уровне составления шаблона (тайтла, Н1, ЧПУ), а частота их не столь велика, чтобы проявлять повышенный интерес к детальной проработке. Так что пробиваете фразовую частотку, если она не велика, то можно спокойно работать шаблонами, пока не исчерпаете все другие возможности более быстрого привлечения поискового трафика. Это сильно сэкономит время на работу с ядром. Если что, потом всегда можно будет расширить семантику и детально пройти каждый из ста тысяч ваших товаров.

-

Тут все просто. Берем ядро по Москве, обрезаем топоним, пробиваем по Владимиру, расширяем ядро по Владимиру. При парсинге ключей по небольшому городу полнота бывает небольшой — это нормальная ситуация, ее можно нарастить ключами из других регионов и вообще третьих источников, например, подсказок.

-

Тут много вариантов решения. Исходить надо больше из бизнес-составляющей. Есть, например, классический случай, когда кластеризация по выдаче дает много мелких кластеров, но в вашем регионе или нише это один интент. Тогда укрупняем кластеры вручную согласно интентов. Если интент отличается, то делаем новые посадочные. Если интент отличается, но нет возможности расшириться по числу посадочных (например, это лендинги) — укрупняем посадочные, вводя кластеры инфоблоками. Если вообще толком ничего нельзя поменять — такое тоже случается, например, клиент хочет жестко тагетироваться на каких-то мелких но маржинальных для него интентах, тогда урезаем ядро.

-

Интент один? Один. Тогда и вопроса нет — на одну. Другой вариант — сделать лендинг на субдомене/другом домене и оптимизировать его под один из вариантов ключа, а на основном сайте оставить оптимизацию под базовый более частотный ключ. И продвигать два сайта. Пример такого решения: промосайты по «раскрутка сайтов» у некоторых контор по продвижению на субдомене promo.* — основной сайт оптимизируется под «продвижение сайтов».

В целом же по всем вопросам хочет услышать понимание от кандидата в оптимизаторы, что он понимает несколько простых вещей:

-

сначала делаем самое простое и быстрое к внедрению, стараемся не уходить в дрочерство на нюансы-детали и перфекционизм на старте работы с проектом,

-

терминология в поисковом продвижении, как и любой молодой отрасли, может плавать,

-

интент решает,

-

выдача не статична, любые разборы на основании выдачи дают слепок, верный на момент снятия и завтра ситуация может измениться,

-

догматизация любых методик вредна и сказывается на качестве проработки проекта.

Оригинал: http://bablorub.blogspot.ru/2016/11/blog-post_7.html

На внутреннюю оптимизацию

-

Перечислите зоны документа, где поиском фиксируются вхождения ключей.

Традиционно выделяют три основные зоны: тайтл, превью (заголовок, но чаще первое предложение) и текст — возьмем тот же сфинкс или эластик. Добавим к ним еще анкор-лист, который делится на внутренний и внешний. У кого есть список факторов Яндекса — там список сильно побольше, но мы же об общедоступной информации.

Понятно, что поиск в текущий момент не ранжирует просто по формулам. Более того, если обратиться к последним докладам от Яндекса (например, выступление М.Сливинского на неделе Байнета, алгоритмы Rankbrain и Палех), то можно сказать, что машинное обучение в плане анализа текстов шагнуло далеко вперед, и поиск теперь пытается оценить тексты на уровне человека, как бы его глазами.

Это хорошо на словах, но для работы (нам же надо как-то оптимизировать сайты) можно пойти путем реверса и выделить зоны, в которых путем анализа вхождений выявить закономерности. Далее допускаем, что если некие условия составления текстов присутствуют в большинстве документов в топе, то именно они приводят к удовлетворению условий поиска. Именно так и поступают текстовые анализаторы, присутствующие на рынке. Выделяя условные зоны: тайтл, заголовок, малый текст, большой текст, анкоры ссылок, альты картинок и так далее — получается некий анализ вхождений. Если он на выдаче подчиняется некоей закономерности (встречается с некоторой погрешностью у большинства сайтов в топе), то можно принять его как набор характеристик, считаемых поиском хорошими для данного запроса.

Так что правильный ответ заключается в поиске закономерностей распределения вхождений по условным зонам документа на выдаче. Если таковая закономерность находится, то можно использовать ее для оптимизации документа. Если нет, то вы или некорректно выявили зоны документа, или дело тут вообще не в этом — слишком велико влияние других факторов.

Про последнее — показателен доклад Стаса Поломаря с DDS-3, где он показывает, что влияние оптимизации по текстовым анализаторам более заметно в конкурентных ВЧ, где у большинства сайтов остальные факторы дожаты до максимума.

Слабость гипотезы по реверсу в том, что возможно есть широкий набор условий, который может привести к тем же результатам, просто на данный момент нет документов, которые были бы по ним созданы. Но в условиях масштабной проработки сайтов можно этим и пренебречь: проще взять восстановленный реверсом набор условий, чем гадать и фантазировать на тему, что такое хороший текст по данному запросу.

-

Распределите приоритет размещения ключей по зонам документов.

Классически наибольший приоритет у тайтла, потом у превью (заголовок, верхняя часть текста), дальше текст. Внутри текста играет роль выделение и порядок слов (подряд или нет). Но это так было. На сегодня данные правила не дают стопроцентной гарантии и надо смотреть конкретный топ по конкретному запросу. Говоря проще, изначально делаем согласно классическим правилам, дальше смотрим, что не вылезло в топ и правим с помощью текстового анализатора. Если и это не помогло, то дальше только тесты.

-

Как увеличить шанс попадания нужного куска текста в сниппет яндекса? В сниппет гугла?

Найдите доклад Стаса Поломаря к ашмановской конференции 2014 года. Для гугла вхождение ключа в дескрипшн почти стопроцентно гарантирует его подстановку в сниппет. Для яндекса — предложение с вхождением ключа как можно по тексту длиной от 120 до 200 символов дает вероятность в 60%. Есть еще техники тюнинга, когда ловят кусок текста в сниппете, а потом модифицируют его уже в документе под свои требования. Тоже вероятностная техника. В некоторых случаях в сниппет попадает описание из Я.Каталога, но на это я бы не ставил — с текстом работать проще, а каталог отключить через noyaca в метатэге.

-

Как подставить адресную информацию в сниппет яндекса?

Добавить страницу в Я.Справочник. Именно оттуда подгребается адресная информация в сниппет.

-

Как подмешать в текст документа ключи с грамматической ошибкой?

Это совсем просто. Иногда надо запихнуть в документ ключи с ошибкой. Ну вот очень надо — допустим, эта ошибка не исправляется поиском. Или прямое вхождение ошибочного ключа дает преимущество в ранжировании в данном случае. Есть еще случаи множественного написания торговой марки или бренда, когда каноническим (или разрешенным в документе) является только один или два варианта (например, несчастный бош/bosch, как его только не пишут). В этом случае есть два варианта: отзывы/комментарии и внутренние/внешние ссылки с вхождением ошибочного ключа в анкор.

-

Как ускорить реиндексацию документа после изменений? Назовите как можно больше вариантов.

— Панель вебмастера.

— Пинг в поиск.

— Соцсети.

— Сайтмап.

— Хабы:

— Собственный сайт: главная, первый уровень от главной.

— Главные страницы практически любого сайта.

— Форумы, новостники.

Из опыта — на сегодня рулят хабы. Просто меняя ссылки на главной собственного сайта можно загнать за

1-2 апа в индекс все нужные страницы небольшого сайта. Ловец ботов — это просто усовершенствованная работа с хабами, делающая хабом любую страницу, посещаемую поиском. Ротатор ссылок — это упрощенный ловец, построенный на вероятности, что боты посещают часть страниц на сайте в любом случае. -

При обычном поиске по фразе — нет, это разные пассажи. Документ или не будет находиться или будет показываться после всех вариантов вхождения в один пассаж. При цитатном поиске документ будет показываться. Цитатный поиск игнорирует пассажи.

-

Вопрос-ловушка. Все от запроса зависит. Смотрите топ. Или можно составлять конструкции вроде [(!пластиковые /1 !пвх /1 !окна /+4 !дешево) | (!пластиковые /+4 !пвх /1 !окна /1 !дешево)] и сравнивать результат, какие сайты выше (слово !пластиковые тут просто чтобы отбить от него три слова до фразы «пвх окна дешево»), но это кривоватенький способ для рассматриваемой задачи, так как слишком много меняет в расчете ранжирования.

-

Как привязать сайт к 40 регионам без субдоменов?

Через Я.Справочник. Делаем 40 страниц с адресами, каждую регистрируем в справочнике, ждем. Если модераторы пропустят, то привязка состоялась.

-

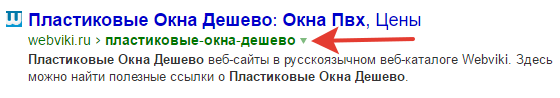

Как в хлебную крошку в выдаче запихнуть свою фразу?

Речь о таком вхождении.

Микроразметкой. В гугле почти всегда получается, в яндексе — реже.

-

Что дает наличие sitemap у сайта?

Sitemap — рекомендация для поиска. Можно указать страницы, на которые нет пути через ссылки на сайте. Можно задать приоритеты для обхода ботами. Можно вывалить в сайтмап только страницы не в индексе. Т.е. для небольших сайтов толку от сайтмапа почти никакого.

-

От топа к топу допустимые границы могут быть разными, но если у вас есть прямое вхождение в разные значимые зоны, то вероятность переспама сильно возрастает. Например, прямое вхождение ключа в тайтл, в Н1 и несколько раз по тексту. Одинаковое вхождение в альты нескольких картинок наряду с вхождением в тайтл и Н1. Одинаковое вхождение ключа в тайтлы и анкоры внутренних ссылок, наряду с вхождением в тайтл или Н1. И т.д. Отдельно стоит выделить переспам по внутреннему или внешнему ссылочному, так как он не очевиден при просмотре документа: большое количество ссылок с одинаковым анкором как внешних, так и внутренних, может привести и само по себе к переспаму, и в совокупности с вхождениями в документе. Дополнительно будет усугублять вхождение как в вордстате, игнорирующее правила русского языка.

При этом надо повторить, что есть запросы, по которым это не будет переспамом, так как границы допустимого там гораздо выше.

Что самое важное?

Показать, что вы понимаете, что на сегодня жестких правил внутренней оптимизации нет. Но при этом проще следовать каноническим правилам для упрощения работы по большому числу посадочных, а потом дожимать страницы, которые пошли вниз или остались на месте по своим запросам, точечно с помощью текстового анализатора или тестов.

Оригинал: http://bablorub.blogspot.ru/2016/11/2.html

На фильтры

-

Если речь о Яндексе, то вероятнее всего — переоптимизация. Более подробно можно посмотреть у Пикселей (в проекте Самостоятельно) в их статье по описанию фильтров. Или доклад Артура Латыпова по фильтрам. Почему? Вероятнее всего, изменились границы переспама по нише. Было все хорошо, но появились более качественные сайты и подвинули границу вниз, и вы — просели.

Для нового фильтра (ограничение в ранжировании) характерно выпадание кусками по ядру. Минусинск — нет причин по ссылочному. ПФ, кликджекинг — вылетело бы за топ50, как минимум. АГС — нет и он прекрасно диагностируется.

-

Есть два варианта. Быстрый — в надежде на эффект ссылочного эха в гугле. И медленный — снятие слоями от худших к лучшим. Быстрый — снимаем все и надеемся, что ссылочное эхо от снятых ссылок пребудет с нами длительное время. Действительно, просадка в гугле бывает, что происходит не так уж и быстро после снятия. Но чаще наоборот. Медленный путь: скоринг ссылок. Можно использовать чектраст, выгребая из него показатели доноров по разным сервисам, или высчитывая свой KEI. Но суть одна — вы присваиваете каждой ссылке коэффициент, стараясь максимально приблизить его к условиям расчета в рамках мадридского доклада (ничего другого все равно нет, чтобы понять, что такое платная ссылка). И дальше срезаете по 10% ссылок за раз. Или в какой-то момент вы перевалитесь за планку, выше которой сайты с назначенным минусом и выйдете из-под фильтра. Или ничего не произойдет. Пересчет минуса обычно — где-то раз в месяц. Т.е. максимальный срок — до 11 месяцев от начала работ, но проекты, где требовалось снять все ссылки — редкость. Впрочем, срок может быть выше из-за проблем со снятием статичных ссылок.

-

Панель вебмастера — показы/клики. Сравнивать с более ранними сроками, искать аномалии, прежде всего резкий рост CTR или аномальный CTR для позиции. Обычно крутят

5-20 фраз, размывая между ними накрутку, но поведение все равно будет отличаться. Второе место куда смотреть — метрика: появление переходов по ключам, по которым раньше не ходили на сайт. Вас могут накручивать и по продвигаемым запросам — но там сложнее увидеть прибавку от накрутки, и по совершенно другим. По обоим вариантам будет, как минимум, кратковременный скачок в позициях: улучшение, потом откат. Умную накрутку вы никак не увидите, так как это будут ваши основные трафиковые фразы, их будет довольно много, прибавка от накрутки не будет большой, кликабельность тоже размоется и рост CTR не будет заметным. Т.е. вам не будут крутить фразы в топ30. Вам будут крутить фразы в топ10. И против этого лома приема не придумали пока. А разовые аномальные сессии в вебвизоре никому ничего не докажут. -

Новый фильтр. Или так называемое «ограничение в ранжировании». Характеризуется резким снижением позиций по большим группам запросов. Легко диагностируется на большом ядре, когда целые группы похожих запросов имеют заметно более низкие позиции или позиции за пределами топ100. Лечится, как и переоптимизация.

-

Какие санкции не переносятся при склейке по 301?

Не переносятся санкции, которые не имеют связи с факторами, которые не изменятся с редиректом. Т.е. были ссылки, пришел Пингвин. Вы сделали 301, по нему перетек и ссылочный вес по старым ссылкам — и снова, привет, Пингвин. Был плохой контент, пришла Панда или Переспам. Сделали 301, но контент не меняется. Вначале будет улучшение позиций, но потом поиск снова насчитает штрафы. Если же ссылки были выключены, но осталось «эхо» от Пингвина, часто называемое постфильтром, то санкции не перейдут. Т.е. постсанкции не переходят по 301. Фильтры Минусинск и за накрутку ПФ — переходят через несколько недель после склейки — наследуются на новый домен. Если успеть отключить склейку вовремя, то можно успеть перехватить часть факторов на новый домен, но не дать перейти фильтру. Гарантий никаких, но кейсы такие есть.

-

В чем принципиальное отличие Минусинска и Пингвина? Пингвина и Пингвина 4.0?

Минус назначается по принципу царя горы: отбирается пул проектов, высчитываются лидеры по ссылочному, верхушке назначается фильтр. Если что-то и изменилось в этом алгоритме, янексоиды в паблик этого не озвучивали. Пингвин просто назначается за «плохие» ссылки. Тут принципиальная разница. Если в нише все сайты используют покупные ссылки, то Минусинск назначат самым плохишам. Пингвин же может прилететь всем сайтам сразу. Конечно, таких кейсов история не знает, но

3-4 сайта из топ10 — такое бывало, когда Пингвин только начал зверствовать. Теперь это встречается реже, но больше потому, что такие сайты и подняться в топ не успевают.Пингвин 4.0 в отличие от обычного Пингвина является частью алгоритма ранжирования, рассчитывается автоматически и не указывается в разделе санкций в панели вебмастера. С одной стороны, это теперь затрудняет диагностику фильтра. С другой, улучшает шансы на выход из под Пингвина. Автоматический Пингвин наблюдался и ранее, он также не указывался в панели. И точно также лечился не в апдейты Пингвина, а гораздо быстрее. Теперь же просто ручного Пингвина нет. Да и тот что был, давно уже назначался редко, а последний ап был почти два года назад. Так что наверно и слава Богу, что гугл перешел на автомат.

На внешнюю оптимизацию

-

Приведите, как выглядят безанкорные ссылки.

Это когда в анкоре стоит адрес сайта. Также есть словарь слов, для которых в качестве анкора может попадать в анкор-лист не само слово, а то, что стоит справа/слева от него. Это я о словах типа «тут» и «там». Но чаще, конечно, безанкорка — это адрес конкретной страницы или сайта.

-

Из каких зон может подшиваться в анкор-лист у безанкорных ссылок?

Обычно берется кусок текста справа от анкора. Реже — слева. Еще реже из других значимых зон, выделенных в документе, например, заголовок в Н1.

-

Если документ находится по анкору ссылки (с выставленными расстояниями и точным вхождением), то влияние по динамическому есть. Некоторыми специалистами оспаривается мнение, что вхождение в анкор-лист анкора является подтверждением передачи динамического веса. Действительно, померять сам вес так не получится, но поскольку практика говорит, что ссылки, обнаруживаемые таким образом, влияют на ранжирование, то можем заключить, что они все-таки влияют. И равно обратное. Опять же некоторыми оспаривается, что если документ не находится по анкору ссылки, то ссылка все равно может влиять. Но пока нет никаких достоверных исследований, показывающих, что такие ссылки хоть как-то влияют на ранжирование. Так что можем принять, что или это влияние микроскопично, или его вовсе нет.

Пример запроса можно найти в статьях Людкевича, Севальнева или презентации моего доклада с недели Байнета.

Самый простой способ анализировать влияние всех ссылок по динамическому весу — это делать все анкоры на один документ 1) разными (например, добавляя какие-то слова к ключу), 2) исключать точное вхождение анкора в продвигаемый документ (с точностью до расстояний).

Для тех, кто не в курсе, как составить запрос с расстояниями, могу только к справке Яндекса отправить.

-

Приведите как можно больше признаков seo-ссылки.

Гуглим статьи по мадридскому докладу, доклад Гладких по Минусинску. Нахождение ссылки в шаблоне (оформлении сайта: сайдбар, поддон, хидер), анкор равен ключам из семантики для сайта или посадочной страницы, замусоренность исходящими ссылками донора (усугбляет наличие ссылок на сайты разной тематики), синтетические параметры замусоренности (малое число входящих ссылок по сравнению с исходящими), низкое качество донора (шаблон, контент, преимущественная посещаемость с поисковых систем). Сам по себе один или даже группа признаков может не повлиять, но совокупность легко позволить квалифицировать ссылки как платные и, как минимум, не учитывать (или дисконтировать) вес с них. А как максимум, назначить фильтр.

-

Приведите варианты источников условно органических ссылок на продвигаемый проект.

Регистрация в живых качественных справочниках, рейтингах. Наличие ссылок в живых профилях пользователей (форумы, базы пользователей чего-либо). Ссылки в промежуточных сайтах (соцсети, ютуб, слайдшаре и т.д.). Ссылки с ваших поставщиков или закупщиков. Ссылки с релизов в СМИ и блогах. Ссылки на какой-то виральный материал на вашем сайте: инфографику, видео, хорошую статью. Сборники, дайджесты материалов с разных сайтов. Аккуратные безанкорные рекомендации на форумах и отзовиках.

-

Жирный сквозняк на 1000 линков с одного домена или 10 линков с разных доноров помельче?

Обычно второе лучше. Хотя, конечно, это сильно идеализированная ситуация. Анкорная сквозная ссылка — это плохо. Безанкорная может помочь сильно с улучшением индексации. Но одиночные линки тоже могут пойти с мусорных ресурсов и оказаться по сумме сильно хуже одной сквозной. Однако, именно так выбор редко стоит и чаще просто аккуратно наращивают оба варианта.

Оригинал: http://bablorub.blogspot.ru/2016/11/3.html

На стратегию

-

В нише на

1-2 коммерческих места — остальные заняты агрегаторами. Что будем делать?Два очевидных решения: делать свой агрегатор. Но это не всегда возможно по ассортименту. Надо понимать, что эмулировать большой ассортимент не у всех получится. Самый красивый пример я видел, когда одна автошкола была представлена в виде справочника водителей-учителей. На любой вид обучения ротировали разные подборки из одних и тех же двадцати учителей. Второй вариант: это острова контента или монополизация выдачи — все ее по разному называют. Что можем, выжимаем из своего сайта. Что не можем, анализируем выдачу, ищем где можно в ней встать. Иногда это страницы агрегаторов, которые вы можете продвинуть в топ. Иногда паблики. Иногда топики на форумах, статьи в блоги, в которые можно зайти комментарием со ссылкой. Долго, муторно, но хоть что-то. Параллельно развиваем крауд — в таких случаях он может давать даже больше трафика чем органика. Т.е. не просто ищем, куда встать со своим комментарием, но и производим такие топики. Еще можно развивать два типа сеток. Одна сетка на заполнение по НЧ — тут все понятно, пытаемся попасть в запросы, в которые не попадает основной сайт, но они тоже НЧ. Вторая — на аффилиат. Сознательно созданные аффилиаты могут разнонаправленно выходить в топ, как итог — занято больше позиций, чем с одного. Далеко не все из перечисленного имеет смысл в каждом конкретном случае, но знать об этом надо.

-

90% конверсий идет с 5% ультраВК запросов из ядра. Ваши действия?

Та самая ситуация, когда нет смысла качать семантику. Надо стараться выйти в топ по этим ультраВК. Любыми способами. Работать с НЧ нет никакого смысла.

-

Тут просто: укрупняем кластеры. Ключей будет охвачено меньше, но все же больше, чем изначально. Нет никаких правил, запрещающих размещение на одной странице контента на несколько десятков ключей. Кластеризация по выдаче — это слепок топа, рекомендация, как лучше на сегодня в сложившейся коньюктуре. Но слабое место тут: то, что могут быть другие решения по кластеризации, которые просто не реализованы в виде сайтов. Соответственно, из-за недостаточной полноты по числу возможных ситуаций с контентом мы и получаем то, что получаем. Не бойтесь укрупнять, если не видите потери интента. Хотя даже разносмысловые ключи но в одной теме можно запихнуть на одну страницу, если делать это разными блоками: живой пример — лендинги.

-

Переукрупнять. Не стоит избыточно плодить категории и тэговые листинги. Больше чем число товаров — уже рисковано, слишком попахивает спамом. Я бы даже сказал, что есть вероятность, что листинги в некоторых категориях будут одинаковыми.

-

У сайта две версии для России и Беларуси. Обе на русском языке. Как будем их продвигать?

Да никак. Сделать геопривязку и скрестить пальцы. Никаких запретов на ранжирование домена с контентом на том же языке в другой национальной зоне настроить нельзя.

-

Какая стратегия для сайта отеля даст оптимальный результат? Почему?

В первую очередь: работа с агрегаторами и отзовиками. Сайт отеля выводим в витальный ответ по названию отеля (а это не всегда так). Дальше наращиваем через отзовики частотность брендового запроса. И остальное добираем по инфозапросам (блог, например) и через трафик с агрегаторов и крауд.

На аналитику

-

Давайте думать. Если вы произвели изменения, то трафик должен был вырасти от подъема позиций по разным ключам. Т.е. надо взять ситуацию «до» по позициям. И после. И сравнить с нормировочными коэффициентами. На пальцах. Фраза1, позиция 5, частота 50. Фраза2, позиция 2, частота 30. После изменений Фраза1 выросла до топ3, Фраза2 упала до топ5. Трафик вырос по обоим. Но с нормировкой получаем примерно тот же результат.

Есть, конечно, очевидный случай, когда значительная доля фраз выросла по позициям. Но и тут проверка с нормировкой не помешает: встречались случаи, когда просадка небольшого числа запросов существенно сказывались на трафике в целом. В идеале с нормировкой с точностью до спецразмещения, но и так сойдет для большинства сайтов.

Другой случай, это когда у вас огромное количество ключей. Но решается за счет исследования по репрезентативному объему. Допустим, вы запили изменение шаблона на 1млн страниц. Как понять? Вы же не храните позиции (да и снимать не будете) по нескольким миллионам фраз. Можно отобрать наиболее трафиковые запросы и снять видимость по ним до и после.

-

Видимость проекта в поиске — как вы ее будете считать?

Выше уже проговорился — нормировка по позициям. Есть разные оценки. И разные сервисы. Например, серпстат утверждает, что считает видимость с точностью до экрана сниппета. Топвизор и раш используют формулы. Есть и несколько исследований (например, прошлый год, доклад на Ашмановке Сливинского и Поломаря), где даны выкладки по кликабельности на топе. Можно и на основании данных из своего вебмастера получить данные относительно своей ниши, но это, конечно, если там ключей несколько тысяч набирается.

-

Сезон. Или какие-то события, влияющие на спрос. Например, рост курса доллара сильно сказался на трафике в магазинах. Снятие с производства сериала обвалит трафик по запросам, с ним связанным. Весной пик по броням в курортных отелях, к августу он стремительно падает и дальше до весны барахтается около нуля.

Есть еще одна версия. Действия привели к вгону в топ большого числа НЧ, но профакапили потерю ВЧ. И да, такое бывает, когда оптимизатор наслушался лекций про выжигание семантики и вместо подумать внедряет все ядро целиком, убивая трафиковые посадочные. Если что-то в топе — не трогайте. Никогда.

-

Тут коротко не ответить. Я бы хотел, чтобы человек начал объяснять про ценность запроса, как можно его оценить. Понятно, что можно связать запрос с конкретной конверсией. Но пока будешь ждать этих конверсий — устанешь. Поэтому можно предложить другие оценки ценности запроса. Например, присутствие в топе коммерческих сайтов, конкуренцию на серпе (как бы кто ее не считал), длину конкуренции на серпе, число участников в контексте, ставки в контексте. Просто конкуренции будет недостаточно, так как иной раз больше конверсий идет с не самого конкурентного топа. Кроме того, надо делать коррекцию относительно самого сайта. Агрегатор и корпоративный сайт конвертятся далеко не одинаково по одним и тем же ключам.

В целом по стратегиям хочется услышать рассуждения и условия для возможных экспериментов, а также понимание, что достижение результата в поисковом продвижении — это итерационный процесс, а не сделал-получил. Ты что-то делаешь, что-то выходит, а что-то — нет. Твоя задача — поймать показывающее положительную динамику и пытаться это развить в рамках данного проекта. А для аналитика необходимо еще и уметь такие вещи масштабировать. Например, частая ошибка в исследованиях — выводы на малой выборке, с отстствием антигипотез. Было бы прекрасно, если бы частный кейс всегда повторялся на других проектах, но в реальном мире это не так. Нынче поиск — это набор вероятностей при воздействии на какие-то факторы определенным способом. Поэтому, как ни странно, отсутствие глубоких знаний в именно поисковом продвижении при хорошей способности к анализу и развитой логике будет лучше, чем справочник в голове. Толку от формул и знаний, если они не сработают в частной ситуации? Это не значит, что учить базу не нужно. Но базу можно качнуть и инхаус. А логическое и аналитическое мышление — оно или есть, или его нет. Если нет, то выше джуна в нормальной конторе не подняться.

Оригинал: http://bablorub.blogspot.ru/2016/11/blog-post_16.html

Ищете исполнителя для реализации проекта?

Проведите конкурс среди участников CMS Magazine

Узнайте цены и сроки уже завтра. Это бесплатно и займет ≈5 минут.